Des Agents très spéciaux.

Je n’y connais à peu près rien en génération de vidéos. J’ai fait joujou avec des outils de montage comme iMovie et même Final Cut (quel gâchis de me mettre cette puissance entre les mains). Mais je n’ai jamais créé en digital from scratch : j’avais toujours sous la main des rush shootés à l’iPhone et de la musique. Et je m’improvisais monteur (souvent pour des projets scolaires des kids).

Alors quand j’ai découvert The Next Stories, je me suis précipité pour voir. J’ai dû passer quelques semaines au purgatoire de la waiting list. Et j’ai pu y accéder vendredi dernier…

Cette plateforme/app accompagne les créateurs dans leur production visuelle animée.

Leur produit principal semble tourné vers la production de bande-annonce (des teasers donc). Cet article peut avoir deux lectures :

- vous êtes intéressés dans la production visuelle et souhaitez découvrir un bout du futur.

- vous vous demandez ce que c’est que tout ce battage sur les agents genAI. Et vous n’allez pas être déçu : adieu l’interface aride et conversationnelle de tous les ChatGPT et bienvenu dans le monde des agents hyper spécialisés qui vous apporte une grosse valeur ajoutée, pas à pas

Pour le.a lecteur.ice ayant peu de temps, nous résumons ci-dessous toutes les étapes de création (et il faudra scroller tout en bas pour voir le résultat complet). Ensuite, nous détaillons les différentes étapes, leurs agents et les IA utilisées.

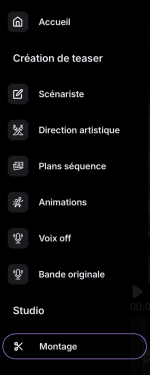

On est intégralement pris en main et guidé pas à pas. Le processus est matérialisé dans la barre à gauche. On comprend donc qu’on va passer par les étapes créatives suivantes :

- Scénarisation : le contexte, les intentions et le découpage en plans.

- DA : (ouais, quand tu veux te la péter, tu dis DA pour montrer aux plus néophytes que toi que tu sais ce qu’est la Direction Artistique). Ici il s’agira principalement de décrire complètement chaque plan et l’ambiance souhaitée.

- Plans séquence : comme chaque plan sera basé sur une image fixe, ces images sont donc générées à cette étape.

- Animation :à partir de chaque image, une très courte « vidéo » est générée (5 secondes).

- Voix et BoF : la partie audio avec le travail sur la voix de narration et la musique d’ambiance.

- Montage : retouches finales avant production.

Rencontre avec Alex, le scénariste

On commence par une discussion avec le scénariste Alex (qui carbure à ChatGPT-4o). Il cherche à creuser le projet : le contexte, le lieu, la date, les personnages et leur caractère, leurs interactions, et comment on prévoit leur évolution dans le contexte. C’est le moment où j’ai collé mon mini-scénario (cf livre en cours de finalisation) qui décrit tout ça.

Une fois ces éléments ingérés, il résume la situation. Bien entendu, il prend en compte les modifications (infatigablement d’ailleurs). Cela conduit à : l’idée générale, le contexte, les personnages, leurs enjeux et le déroulement souhaité.

Ensuite, il crée une structure narrative qui va conduire à la création d’autant de séquences (6 dans mon cas). D’abord il identifie clairement : le titre (« Lune 2054 : Solitude et Espoir » – j’ai pas été vigilant et ai laissé ce truc un peu plan plan il faut l’avouer), le type d’histoire (« Fiction »), et le genre (« Drame / Science-Fiction »), la bio des personnages et le nombre de séquences.

Puis viennent les plans en détails. Le scénariste propose sa perspective et on peut les ajuster avant de passer au suivant. Par exemple pour le premier plan, on a :

Shot Title: Le laboratoire

Shot Content: Anhia est concentrée sur son travail dans le laboratoire, manipulant des échantillons avec des outils de haute technologie. On voit des écrans affichant des séquences génétiques.

Shooting Style: Plan rapproché sur Anhia et les équipements, pour montrer la précision et l’importance de son travail.

Potential Sound Effects: Bips électroniques et le bruit subtil des machines en fonctionnement.

Une fois ces plans définis, on va quitter Alex, notre scénariste qui a terminé son taf.

Direction vers l’artistique Lucy

Passons chez l’agente Lucy, directrice artistique et directrice de la photographie. Mais si mais si, on ne lésine pas sur l’équipe… Comme Alex, elle est dopée à ChatGPT-4o.

On débute l’échange par des considérations générales sur l’ambiance, les décors, les vêtements des personnages…

Ensuite, Lucy va utiliser les éléments du scénario et le découpage en plans pour nous aider à créer chaque situation. Elle émet des propositions plan par plan et nous invite à commenter pour qu’elle ajuste.

Shot Number: 2

Shot Title: Le laboratoire

Shot Content: Anhia est concentrée sur son travail dans le laboratoire, manipulant des échantillons avec des outils de haute technologie. On voit des écrans affichant des séquences génétiques.

Shooting Style: Plan rapproché sur Anhia et les équipements, pour montrer la précision et l’importance de son travail.

Lighting: Éclairage doux et focalisé sur les écrans et les outils, créant une ambiance de concentration.

Color emphasis: Bleu indigo et argenté pour souligner l’aspect technologique.

Potential Sound Effects: Bips électroniques et le bruit subtil des machines en fonctionnement.

Emotional Impact: Met en avant la passion et le dévouement d’Anhia pour sa recherche.

Les directives que Lucy produit seront utilisées par tous les agents qui suivent : des instructions sur le son, sur la partie visuelle et même sur le montage.

Note pour les techos : cela invite à se demander comment sont gérées les Entrées/Sorties de chaque Agent… Il y a probablement un pot commun dans lequel les différents agents vont piocher et déverser leurs prod : ici, cela s’appelle le « Studio », ce qui permet un couplage lâche entre les Agents.

Passons chez Morgane, reine de l’image

Maintenant qu’on a bien avancé sur le découpage et le contenu, passons à la partie visuelle. Morgane, spécialiste en génération d’images pour les teasers cinématographiques, va nous proposer son interprétation visuelle de chaque plan.

Généreusement, elle nous génère 4 interprétations visuelles par plan. Son petit cœur bat au rythme de MidJourney. Elle nous montre même les prompts qu’elle utilise. On peut sélectionner l’image qui nous plaît et lui demander des modifications.

Le petit hic, c’est qu’elle n’utilise pas toute la puissance de l’engin, car je n’ai pas vu l’utilisation du paramètre qui permet d’avoir des personnages récurrents/cohérents – le truc qui permet d’avoir des variantes du même personnage plutôt que des personnages proches mais différents à chaque image générée (pour les intimes, il s’agit entre autres de « -cref« ). Ce qui fait que les personnages sont ressemblants mais pas identiques d’un plan à l’autre. Rien que la plateforme ne puisse corriger plus tard (par exemple en ajoutant une étape de génération des personnages uniquement – lesquels pourraient ainsi être injectés dans chaque plan ensuite)

Donnons un peu de vie à tout ça

Donc on a les visuels. Un par plan. Six au total. Rien de plus simple que de les animer un peu.

Enfin, rien de plus simple… Disons que ça prenait des jours et des jours par le passé. Là, assis confortablement derrière son écran, on devient metteur en scène.

L’agent qui nous épaule est anonyme (pour l’instant certainement) mais il est porté par des grands noms.

Avec l’indication de leur qualité, vitesse et coût (je vous ai bien dit que ce n’était pas gratuit? tout d’un coup j’ai comme un doute 🤔)

Donc on choisit le modèle, et on peut donner des indications pour animer. Sans indication particulière, l’agent utilise les informations des étapes précédentes.

Alors, laissons-lui libre cours…

« Argggg. Coupez! Je dois briefer les acteurs. Où est la responsable des effets spéciaux qui s’est un peu trop lâchée ? Mais c’est quoi cette idée du personnage masculin qui sort de l’écran ? et en plusieurs exemplaires en plus… On a dit qu’on était dans le futur du côté de 2054 et qu’on avait un système de visio en 3D. Pas un truc délirant. Et puis pourquoi les acteurs ne se regardent-ils pas ? » (on devient vite tyrannique quand on vous met dans le fauteuil de « Stage Director », hein?)

Heureusement qu’on peut donc corriger cela et trouver une alternative plus satisfaisante… Mais on attendra la vidéo complète pour montrer le résultat…

Léa, productrice et doubleuse de voix off

Bon on a donc des visuels animés. Avant de finaliser le montage, il nous manque un peu de son : on va commencer par la narration.

C’est Léa, avec la complicité d’ElevenLabs, qui va nous aider à trouver une voix pour la narration. Mais avant cela, elle relit le script et les éléments à disposition pour élaborer le texte de la voix off. Après une discussion entre elle et moi, on aboutit à un texte qui devrait accompagner correctement la vidéo.

Ensuite, elle propose trois voix sur étagère (i.e. elles n’ont pas encore accès au texte et se mettent en avant pour que vous la choisissiez). Si le choix standard ne vous convient pas, vous pouvez donner des indications (perso, j’ai dit « une voix féminine, peut-être un peu plus grave que celle de Rachel, qui mélange le professionnalisme et la dimension émotionnelle »).

Et là, un petit glitch est apparu (je vous ai mis une partie qui fonctionne et une partie qui … comment dire… est un peu cryptique, non?)

On regenère est c’est réparé. Ouf, trop facile. (et oui, je vous accorde que la voix est un chouia métallique)

Un petit fond sonore ?

Nous passons avec Hans, notre compositeur de bande originale taské pour notre bande annonce.

Avec toutes les infos dont il dispose, il peut nous proposer une bande son.

Et j’avoue que je n’ai pas chipoté et ai validé directement (impatient que j’étais de voir le résultat complet)

On met tout ensemble

On peut aller voir la table de montage. On y retrouve les 6 séquences animées, la piste de la voix off et la piste pour le BoF.

Certes on peut procéder à de petits ajustements (très très loin de iMovie, autant ne pas mentionner Première ou Final Cut). Mais on trouver bouton télécharger qui nous amène à …

Des agents genAI impeccables ?

C’est le premier usage d’agents genAI bien agencés que je trouve. Ils sont spécialisés (chacun avec son modèle sous-jacent et ses tâches spécifiques), ils collaborent en reposant sur les travail de leurs collègues et ils sont ordonnés pour remplir un objectif commun. Le tout est rendu simple et convivial pour l’utilisateur.

Bien entendu, le résultat final est largement perfectible (il s’agit d’une version alpha quand même). La vidéo est plus qu’imparfaite et les problèmes sautent aux yeux (font pleurer?). Mais ce qui m’a édifié, c’est l’agencement et l’UX qui rend simple un processus long et pénible. Grâce à des agents.

Et donc si vous voulez créer vous aussi vos agents, vous pourriez aimez les articles de cette série, à commencer par le canvas que nous avons mis à disposition.

![Lire la suite à propos de l’article [Et si demain…] Dieu existe… Il est sur 7,83Hz](https://futurepath.fr/wp-content/uploads/2024/12/technologybg7-scaled-e1763832782551-300x200.jpg)

![Lire la suite à propos de l’article [Et si demain…] La DIRH des IA](https://futurepath.fr/wp-content/uploads/2025/03/127116-300x200.jpg)